Si no has comprado El Mundo hoy, te recomiendo que te bajes al quiosco: el especial de tecnología que publica hoy con motivo de los veinte años de la web es de los que vale la pena guardar hasta que amarillee. Entrevistas interesantes, artículos de coyuntura, una cronología histórica con los principales hitos tecnológicos del período 1989 - 2009, perfiles de los veinte personajes más influyentes de la historia de la red… si te gusta la tecnología (y si estás aquí leyendo ésto asumo que sí), es un suplemento con el que seguramente disfrutarás.

En su página 28, me publican un artículo prospectivo, “Tecnología líquida” (pdf), cuyo texto reproduzco a continuación. Además, me citan en “Las caricias del nuevo milenio” hablando de redes sociales, y como miembro del comité de selección de los veinte personajes influyentes de la historia de la red, ejercicio que fue verdaderamente difícil, pero muy entretenido.

A continuación, mi columna:

Tecnología líquida

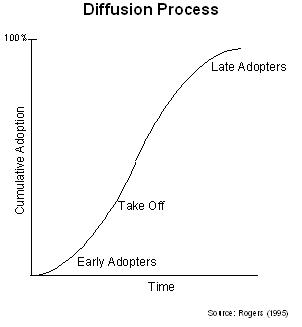

Los líquidos se caracterizan por adaptarse siempre a la cavidad que los contiene, y por penetrar superficies permeables. La tecnología de hoy es como un sólido: vive en compartimentos estancos y definidos. Se asocia a dispositivos concretos, a funciones específicas, a públicos determinados. Hay generaciones impermeables a la tecnología, que se resisten a impregnarse de ésta como si fuese a sustituir o desvirtuar, en lugar de complementar, las actividades que llevan a cabo. Existen políticos que intentan detenerla, como si eso fuese posible, como si alguna vez en la historia hubiesen ganado alguna batalla los del bando que se opone al progreso tecnológico. Hay empresas que la marginan a determinadas áreas funcionales o la restringen a determinado personal, y hasta países que intentan bloquearla para que sus ciudadanos no accedan a ella. Constantemente, nos encontramos situaciones en las que nuestras posibilidades de utilizar la tecnología como querríamos resultan escasas o nulas, bien por la imposibilidad de acceso a un determinado dispositivo, por la ausencia de conectividad o la alimentación eléctrica, o por nuestra pura y simple ignorancia.

¿A dónde se dirige la tecnología en el futuro? Imaginemos un mundo en el que muchas de las actuales limitaciones desapareciesen, una economía de la abundancia en recursos tecnológicos: baterías cuya duración no resultase limitante, conectividad ubicua, dispositivos omnipresentes y de uso sencillo… En algunos temas, la economía de la abundancia ya está aquí: en el acceso a la información, por ejemplo. Nunca en la historia de la humanidad ha tenido una persona tanta información al alcance de su mano, y la posibilidad de manejarla, además, con procedimientos razonablemente sencillos. En los últimos años, se unió al manejo de la información la capacidad de las personas de añadir a ese enorme repositorio su propia información: fotografías, anotaciones, opiniones, vídeos, recursos favoritos, etc. Para un joven despierto, hoy resulta perfectamente familiar manejarse en la red entre una multiplicidad de herramientas para desarrollar estas funciones, herramientas que, además, interactúan entre sí. La tecnología, hoy, está presente en casi todos los aspectos de su vida: cuando accede a información, cuando se relaciona con otras personas, cuando les dice dónde está o qué hace, cuando lee, cuando estudia, cuando se documenta, cuando mantiene conversaciones casuales… y la tecnología no solo está ahí, sino que le acompaña cuando abandona la pantalla del ordenador, a pesar de encontrarse todavía importantes limitaciones para ello.

El futuro de la tecnología es un cambio de estado: de permanecer en compartimentos estancos, a penetrarlo todo, hasta el escepticismo; a empapar todas nuestras actividades. En décadas anteriores creamos protocolos y lenguajes. pasamos de ideas a código. En los últimos años, hemos solidificado su uso y desarrollo. En el futuro, la tecnología estará en todas partes: será una tecnología líquida.

Tras ser objeto de una cierta polémica durante la semana pasada, está ya finalmente disponible el texto del

Tras ser objeto de una cierta polémica durante la semana pasada, está ya finalmente disponible el texto del