Acabo de colgar con el 609 de Movistar. Y necesito escribir algo para que se me quite la cara de pánfilo que se me ha quedado. Para empezar y sentar el contexto, puedes leerte esta entrada antigua, “¿Tima Movistar a los clientes novatos de BlackBerry?“, en la que comentaba cómo Movistar introducía de manera intencionada confusión mediante logotipos casi idénticos para que los clientes de BlackBerry navegasen a través de Emoción en lugar de hacerlo a través de la tarifa plana asociada al contrato BlackBerry, induciendo así un gasto de cincuenta céntimos por conexión.

Acabo de colgar con el 609 de Movistar. Y necesito escribir algo para que se me quite la cara de pánfilo que se me ha quedado. Para empezar y sentar el contexto, puedes leerte esta entrada antigua, “¿Tima Movistar a los clientes novatos de BlackBerry?“, en la que comentaba cómo Movistar introducía de manera intencionada confusión mediante logotipos casi idénticos para que los clientes de BlackBerry navegasen a través de Emoción en lugar de hacerlo a través de la tarifa plana asociada al contrato BlackBerry, induciendo así un gasto de cincuenta céntimos por conexión.

Pues bien, después de aquel episodio, llamé al 609 de Movistar para desactivar completamente mi servicio de Emoción. Sinceramente, fue complicado, pero tras un largo rato de navegación entre los departamentos de un servicio al cliente que se supone diseñado para ayudar y que en realidad hace todo lo contrario (ponerte anuncios, músicas de fondo interminables y pedirte a cada paso datos como tu número de teléfono - desde el que estás llamando, ¿es que no lo ven? - y tu DNI), conseguí la proeza. Tras la desactivación, recibí un mensaje de texto comunicándome que acababa de desactivar mi servicio GPRS… y claro, inmediatamente, ¡¡ALARMA!! ¡¡SOCORRO!! ¡¡La he liao parda, y ahora en vez de BlackBerry tengo un ladrillo completamente inútil!! ¡¡Una BlackBerry sin GPRS es como un jardín sin flores y una rosa sin olores!! Sin embargo, tras comprobar que todo seguía en su sitio, que todos los servicios funcionaban, y que los mensajes se recibían y enviaban con total tranquilidad, decidí ignorar el mensaje y achacar el tema simplemente a una mala redacción.

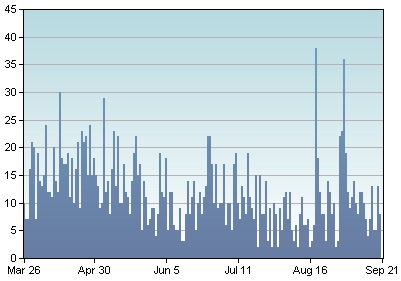

Hasta aquí, hablamos de eventos sucedidos hace tiempo, algo así como año y medio. Pero he aquí que de repente, al ver mi factura de este mes, me encuentro con un cargo de un euro por una conexión de datos realizada el 22 de Agosto… ¿cómo puedo tener un cargo en un servicio que desactivé? Obviamente, el euro me trae completamente al fresco, pero que el servicio de Emoción hubiese vuelto de entre los muertos cual zombie de película de serie B me preocupaba más, porque nunca sabes cuando a alguna de las aplicaciones del BlackBerry le puede dar por utilizar Emoción en lugar de la conexión normal, y dedicarse a engrosar las arcas de un servicio que Telefonica debería, lógicamente, desactivar para aquellos contratos para los que no tiene ningún sentido. O directamente eliminar, porque estoy seguro que se podría demostrar que la gran mayoría de los ingresos de Emoción se reparten entre conexiones erróneas y golpes accidentales con el dedo al botón situado estratégicamente en el centro del teclado en algunos modelos de teléfono.

El caso es que, visto lo visto, llamé inmediatamente al 609 para preguntar qué había pasado. Tras la preceptiva espera y tras tragarme varios anuncios situados en donde el más elemental CRM desaconsejaría siempre su colocación, accedo a hablar con una amable señorita, que me pide el número de teléfono (pues ese que ves ahí, hija… ¿o es que Movistar no paga su propio servicio de identificación de llamadas para ahorrarse un dinerito?) y el DNI, y me confirma que, efectivamente, el servicio de Emoción está desactivado en esa línea. Tras darme un número de referencia, me pasa con otro departamento, en el que me vuelven a pedir tanto el número de teléfono como el DNI (!!!!!!!), para después informarme… ¡¡que yo desactivé el servicio de Emoción a través de GPRS, pero no lo hice a través de GSM!! Pero por el amor de dios… ¿cuántas veces hay que disparar al vampiro con balas de plata para conseguir matarlo? Pero la cosa no acaba aquí: cuando, ya con voz de infinita paciencia, le pido que por favor me desactive el servicio de Emoción a través de GSM, y por si acaso también el que va a traves de tam-tam y de señales de humo… ¡¡me dice que no puede, y que tengo que ir en persona a una tienda Movistar!! O sea, que no solo hay que desactivar separadamente “Emoción a través de GPRS” y “Emoción a través de GSM”, sino que además, el primero lo puedes desactivar mediante una llamada al 609, y el segundo únicamente yendo en persona a una tienda. Genial. Todo muy claro y muy coherente. Y sobre todo, muy emocionante.

(Enlace a la entrada original - Licencia)

Hace un par de días,

Hace un par de días,